原创/朱季谦

2023年12月初,傍晚,在深圳的小南山看了一场落日。

那晚我们坐在山顶的草地上,拍下了这张照片——仿佛在秋天的枝头上,结出一颗红透的夕阳。

这一天很快就会随着夜幕的降临,化作记忆的碎片,然而,总会有一些难忘的痕迹,在逐渐落满灰尘的回忆里,熠熠生辉。这些痕迹,或许是一张随手拍下的照片,或许是聊天记录里的只言片语,又或许,只是朋友圈里一个普通动态......直到很久以后,突然翻到关于这一天的记录,死去的记忆总会从四面八方赶回来,透过这张照片,我一定会想起,那天曾和喜欢的人坐在山顶上一起看过的夕阳。

这难道不是刻舟求剑的另一种体现吗?

2023年就如那天的落日一样,渐渐沉入了岁月的大海。

在这艘岁月的船上,总得刻一点什么文字,方便日后再想起这一年时,不至于一片空白。

下面就分段写一下这一年印象深刻的事情。

一、获得腾讯云社区2022年度最佳作者

在今年年初的时候,很荣幸获得腾讯云社区颁发的“腾讯云社区2022年度最佳作者奖”,这是我写原创编程技术博客以来获得过的第一块奖杯,可以说,意义非凡。

它像是技术写作道路上的一块小里程碑,给了我不少的鼓励。

想起当初刚开始写技术类文章时,就像脚穿千斤鞋,举步维艰,无从下手——虽然在此之前,我已写过近百万字的网络小说和短篇小说随笔等,但是,第一次开始去写技术类文章,还是比较困难的。

现在回过头去看第一篇技术文,可以说很是稚嫩。

虽然现在写得仍是一般,但经过这两年的刻意练习,至少已经不像最初那样举步维艰和无从下手,相反,逐渐有一种得心应手的感觉。

或许,这就是刻意练习之后的熟能生巧,当然,若是展望未来的话,更希望能在熟能生巧的基础上,熟能生“新”。

二、拿到驾照

若是问我在大学的时候,比较遗憾的事情之一,考驾照肯定算一件。

以致于想买车的时候,却连驾照都没有考。

想起当时在深圳报考驾照的时候,还是很担心会踩雷,还好,特别幸运的是,遇到一个很好的教练,在2022年11月底报名,在2023年3月初就顺利拿到驾照。

我在年初有个目的之一是,今年一定要拿到驾照,算是按照目标完成了。

三、跟上ChatGPT潮流

今年上半年,可能最具爆炸性的新闻就是GPT模型了。

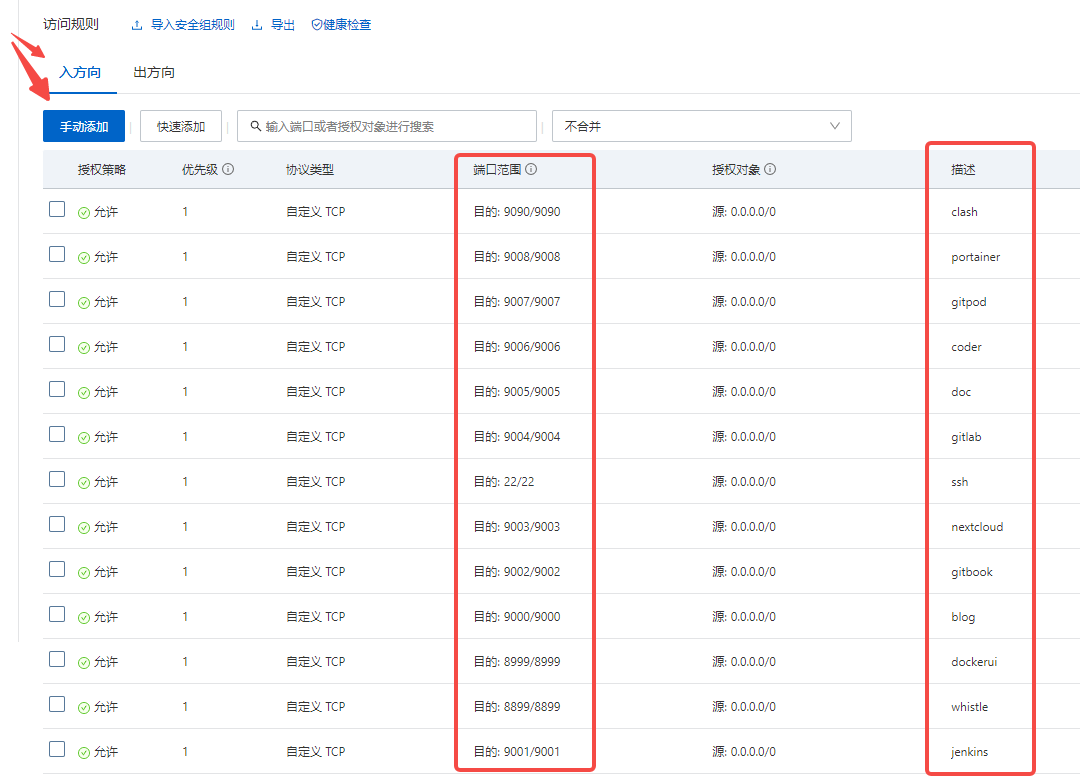

3月份那会儿,在自己的云服务器上通过Docker 部署一套前端仿写Chat GPT页面而内部真实通过ChatGPT 密钥调用外网接口的应用。这样一番操作下来,家里的数台电脑都无需再通过外网即可一键使用GPT。

后来,按照同样方式,给办公司开发团队部署了一套这样的Docker,使得内部团队早早就在工作当中用上了GPT。

直到现在,这套部署仍然运行在我的云服务器上,成为日常工作编程的绝佳助手。

当然,在这个过程当中,2月和3月份那会红利期,通过教人部署以及其他相关提供服务的途径,做了一些变相的尝试,虽然赚的不多,但总归是一次副业尝试。

四、大数据开发技术栈提升

今年比较幸运,有机会参与到内部大数据图计算前沿项目的开发,围绕这个项目,这近一年里将Spark、HBase、Hive、Hadoop、Sqoop等相关的大数据技术栈都在实际开发过程中掌握,算是在后端开发的基础上,拓展大数据领域的开发。

当然,在这个过程当中,还阅读了Spark Core以及Graphx相关的源码,同时还把阅读的心得写成文章,发布到社区,例如《

图解Spark Graphx基于connectedComponents函数实现连通图底层原理

》、《

图解Spark Graphx实现顶点关联邻接顶点的collectNeighbors函数原理

》这两篇,其中,《图解Spark Graphx基于connectedComponents函数实现连通图底层原理》获得了NebulaGraph 技术社区 2023 年年度征文奖。

五、2023年各个博客平台的写作数据

之前写过一个总结这些年写作的感悟:完成比完美更重要。

特别对于新手而言,最好的写作方式,就是不断去写,带着“不要脸”和“老子就是造翔也要写完的心态”去写。写到脑子不够用了,就去看书、看视频等等做各种知识的输入。

写出个上百万字后,你就会发现,当初手里写出的那一坨翔,在多年以后,正逐渐变成文章里所有发光的起源。

每次遇到卡文时,我都是这样告诉自己的,硬着头皮写下去,只有不断写完,不断总结,下一篇才能写得更好。

而不是一上来,就要写出惊天地泣鬼神的完美作品。

这两年开始坚持写技术博客,总体而言,有收获,有不足。

今年记录下来,希望明年的这个时候,对比之下,有一个更好的成长。

5.1、腾讯云社区

说实话,在腾讯云社区退步了些,上半年名次最好的时候是到三四十名左右,中间有两三个月没怎么发文,排名就一直下降。在众多平台里,我算是比较喜欢腾讯云社区,比较有温度,遇到问题,能够及时得到相应的解决,还有很多值得参与的活动。

与此同时,在这里遇到很多优秀的技术写作者,从他们身上,找到了不少榜样的动力。

5.2、CSDN社区

今年比较有突破一点是,入围了CSDN的2023年博客之星,同时关注量超1000了,希望明年这个时候,争取可以拿到TOP名次。

5.3、博客园

最开始技术写作平台,目前园子正经历一段苦难期,还是真心希望它能继续做下去。

5.4、思否

今年开始在SegmentFault思否写东西,很开心之前有一篇《Dubbo2.7的Dubbo SPI实现原理细节》得到了SegmentFault 思否写作挑战赛:写文章领取技术图书活动奖品,算是一次不错的进步。

希望再接再厉,争取今年可以有更多突破。

写了这么多年东西之后,还有一件比较有成就感的事情是,网上搜自己的名字,发现满屏搜出来的,都是自己这些年的产出及相关信息。

在大学的时候,写过很多短篇小说,还有一些长篇小说。

遗憾的是,大学毕业后,开始程序员打工仔生涯之后,就很少写故事了,时间都花在学习各种技术上。

然而,这两年,特别是这一年以来,想写小说的欲望又开始慢慢浮现。或许是经历了一些亲人的离世,明白人总会有一死,那就在生命的终点前,去做一些自己热爱的事情。

我在今年上半年,化名接受过一次谷雨实验室-腾讯新闻一场关于副业的采访,当时有提到自己业余在做的事情。(沈颜云是我正在写的悬疑长篇里的主角名,当时小姐姐问我这篇采访用什么名字好,我就想用自己故事里的主角名了。)

这两本小说,今年一直在存稿,计划是明年顺利投网站走分成签约。

结果无论如何,都希望能继续写下去,无论是技术类写作,还是故事类写作。

六、展望2024年

关于2024年,有以下几个规划:

6.1、技术写作方面:输出同系列内容,希望能写出一本完整的技术电子书。

6.2、故事写作方面:任意一本小说投稿签约成功,连载完结。

6.3、扎实技术的深度能力,阅读更多的框架底层源码,总结成内容输出。

6.4、提高演讲能力和管理能力。

6.5、坚持阅读。

6.6、往出书的方向努力。