Java JVM内存结构的面试常问知识

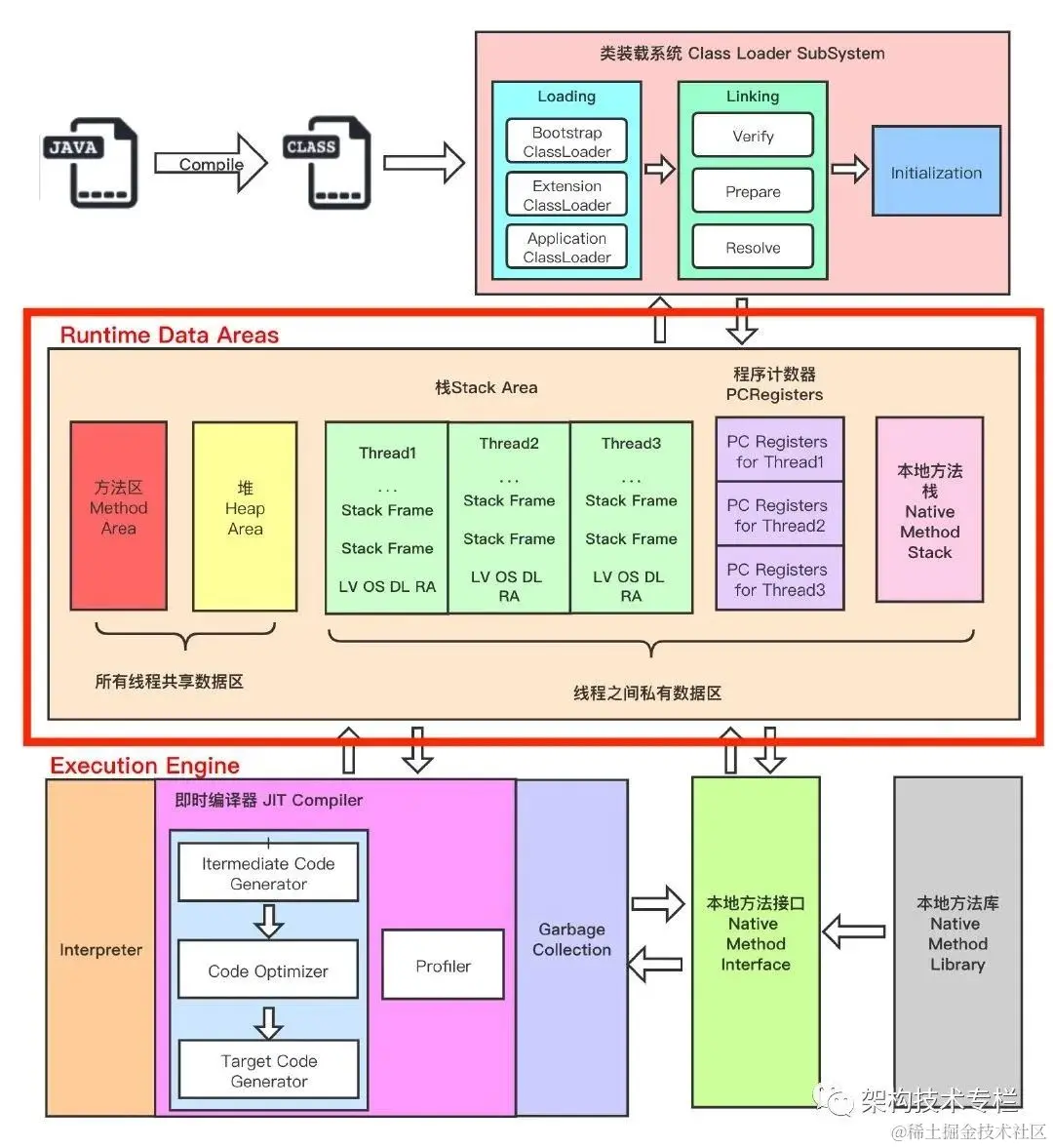

说说JVM内存整体的结构?线程私有还是共享的?

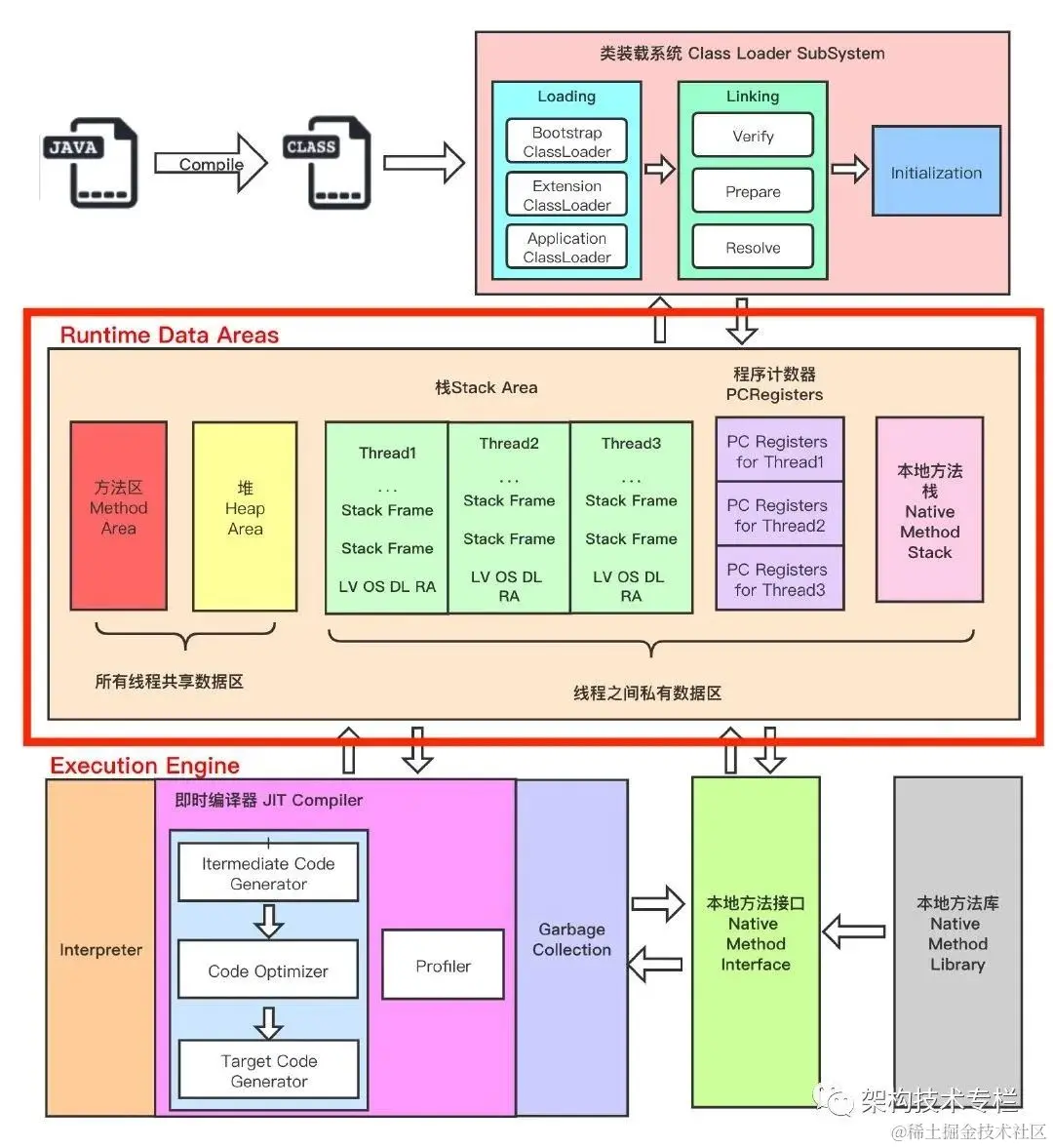

JVM 整体架构,中间部分就是 Java 虚拟机定义的各种运行时数据区域。

Java 虚拟机定义了若干种程序运行期间会使用到的运行时数据区,其中有一些会随着虚拟机启动而创建,随着虚拟机退出而销毁。另外一些则是与线程一一对应的,这些与线程一一对应的数据区域会随着线程开始和结束而创建和销毁。

- 线程私有

:程序计数器、虚拟机栈、本地方法区

- 线程共享

:堆、方法区, 堆外内存(Java7的永久代或JDK8的元空间、代码缓存)

什么是程序计数器(线程私有)?

PC 寄存器用来存储指向下一条指令的地址,即将要执行的指令代码。由执行引擎读取下一条指令。

多线程在一个特定的时间段内只会执行其中某一个线程方法,CPU会不停的做任务切换,这样必然会导致经常中断或恢复。为了能够准确的记录各个线程正在执行的当前字节码指令地址,所以为每个线程都分配了一个PC寄存器,每个线程都独立计算,不会互相影响。

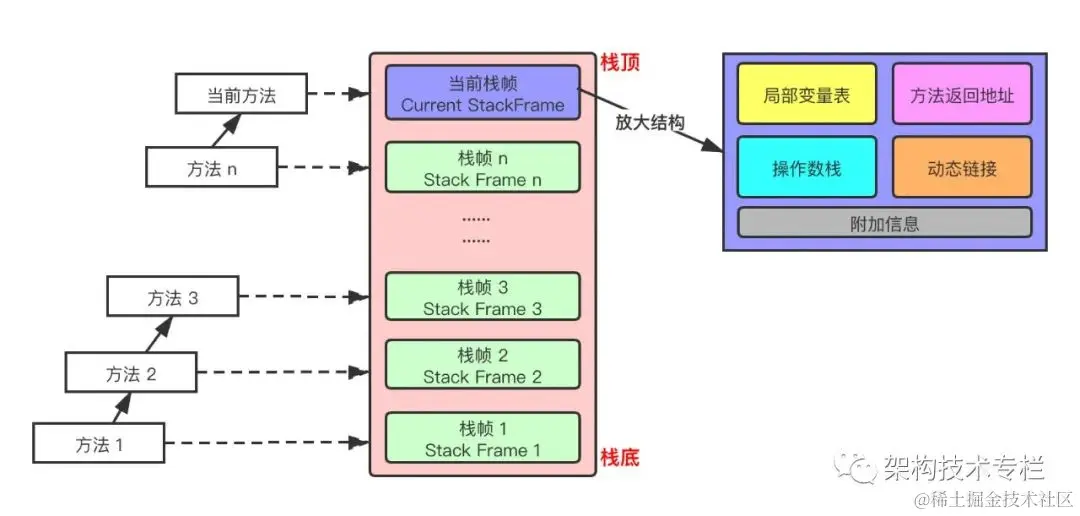

什么是虚拟机栈(线程私有)?

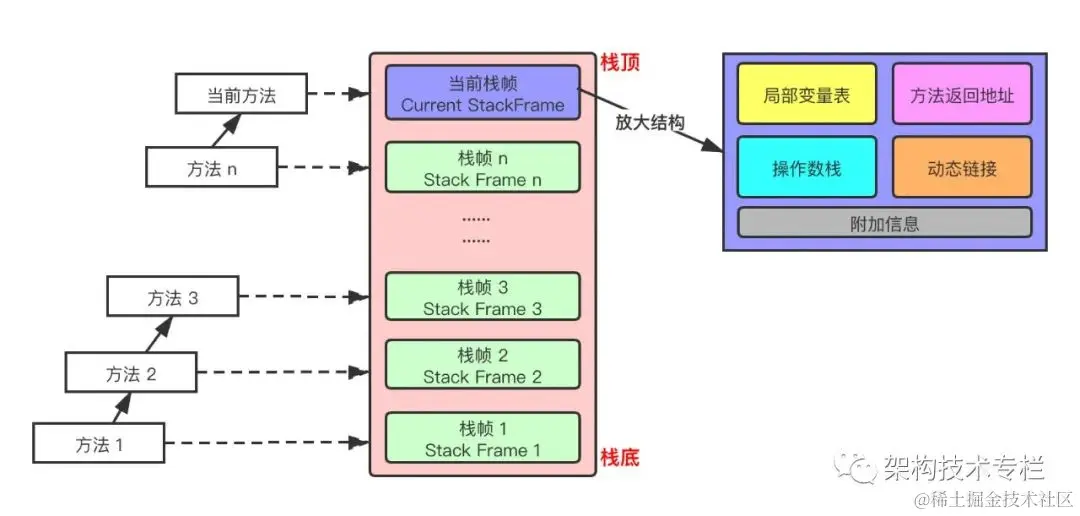

主管 Java 程序的运行,它保存方法的局部变量、部分结果,并参与方法的调用和返回。每个线程在创建的时候都会创建一个虚拟机栈,其内部保存一个个的栈帧(Stack Frame),对应着一次次 Java 方法调用,是线程私有的,生命周期和线程一致。

- 栈是一种快速有效的分配存储方式,访问速度仅次于程序计数器

- JVM 直接对虚拟机栈的操作只有两个:每个方法执行,伴随着

入栈

(进栈/压栈),方法执行结束

出栈

- 栈不存在垃圾回收问题

- 可以通过参数

-Xss

来设置线程的最大栈空间,栈的大小直接决定了函数调用的最大可达深度

- 如果采用固定大小的 Java 虚拟机栈,那每个线程的 Java 虚拟机栈容量可以在线程创建的时候独立选定。如果线程请求分配的栈容量超过 Java 虚拟机栈允许的最大容量,Java 虚拟机将会抛出一个

StackOverflowError

异常

- 如果 Java 虚拟机栈可以动态扩展,并且在尝试扩展的时候无法申请到足够的内存,或者在创建新的线程时没有足够的内存去创建对应的虚拟机栈,那 Java 虚拟机将会抛出一个

OutOfMemoryError

异常

- 局部变量表(Local Variables)

- 操作数栈(Operand Stack)(或称为表达式栈)

- 动态链接(Dynamic Linking):指向运行时常量池的方法引用

- 方法返回地址(Return Address):方法正常退出或异常退出的地址

- 一些附加信息

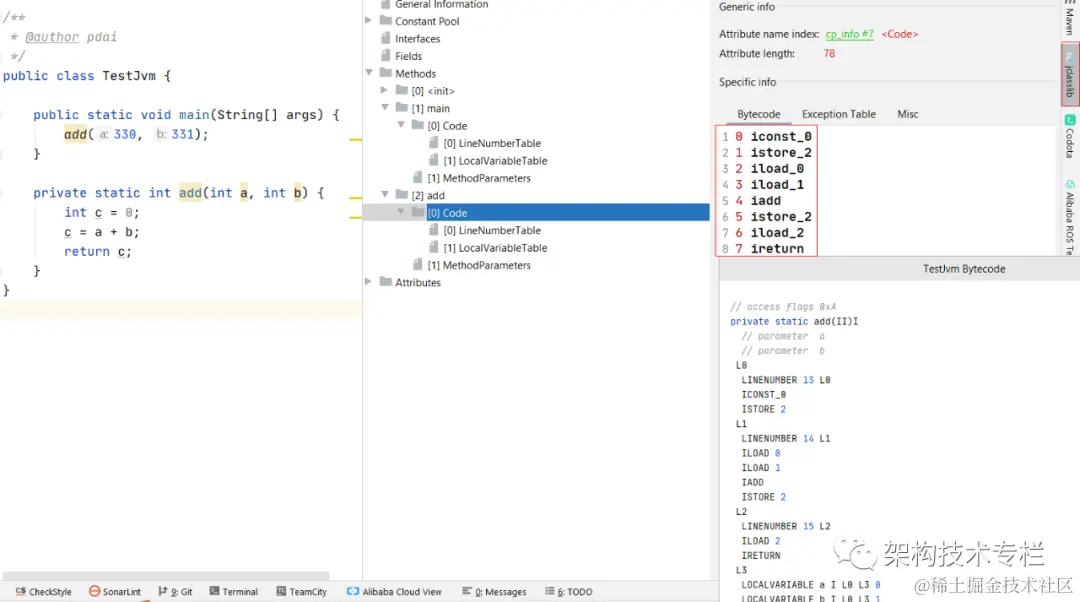

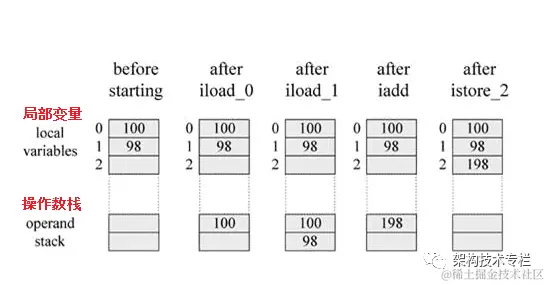

Java虚拟机栈如何进行方法计算的?

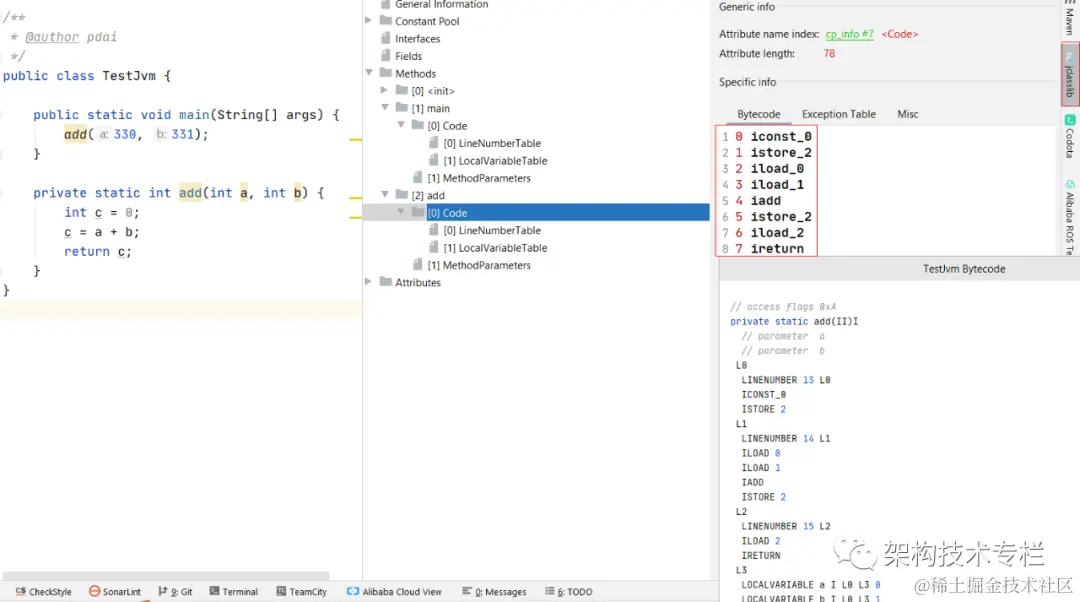

以如下代码为例:

private static int add(int a, int b) {

int c = 0;

c = a + b;

return c;

}

可以通过jsclass 等工具查看bytecode

压栈的步骤如下:

0: iconst_0 // 0压栈

1: istore_2 // 弹出int,存放于局部变量2

2: iload_0 // 把局部变量0压栈

3: iload_1 // 局部变量1压栈

4: iadd //弹出2个变量,求和,结果压栈

5: istore_2 //弹出结果,放于局部变量2

6: iload_2 //局部变量2压栈

7: ireturn //返回

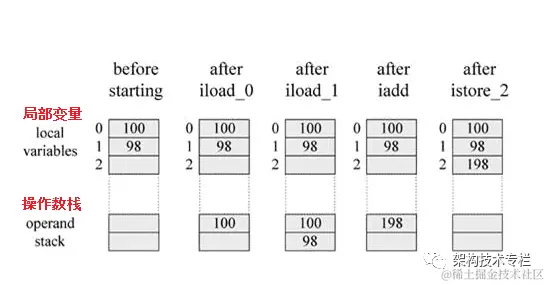

如果计算100+98的值,那么操作数栈的变化如下图

什么是本地方法栈(线程私有)?

一个 Native Method 就是一个 Java 调用非 Java 代码的接口。我们知道的 Unsafe 类就有很多本地方法。

- 本地方法栈(Native Method Stack)

Java 虚拟机栈用于管理 Java 方法的调用,而本地方法栈用于管理本地方法的调用

什么是方法区(线程共享)?

方法区(method area)只是

JVM 规范

中定义的一个概念,用于存储类信息、常量池、静态变量、JIT编译后的代码等数据,并没有规定如何去实现它,不同的厂商有不同的实现。而

永久代(PermGen)

是

Hotspot

虚拟机特有的概念, Java8 的时候又被

元空间

取代了,永久代和元空间都可以理解为方法区的落地实现。

JDK1.8之前调节方法区大小:

-XX:PermSize=N //方法区(永久代)初始大小

-XX:MaxPermSize=N //方法区(永久代)最大大小,超出这个值将会抛出OutOfMemoryError

JDK1.8开始方法区(HotSpot的永久代)被彻底删除了,取而代之的是元空间,元空间直接使用的是本机内存。参数设置:

-XX:MetaspaceSize=N //设置Metaspace的初始(和最小大小)

-XX:MaxMetaspaceSize=N //设置Metaspace的最大大小

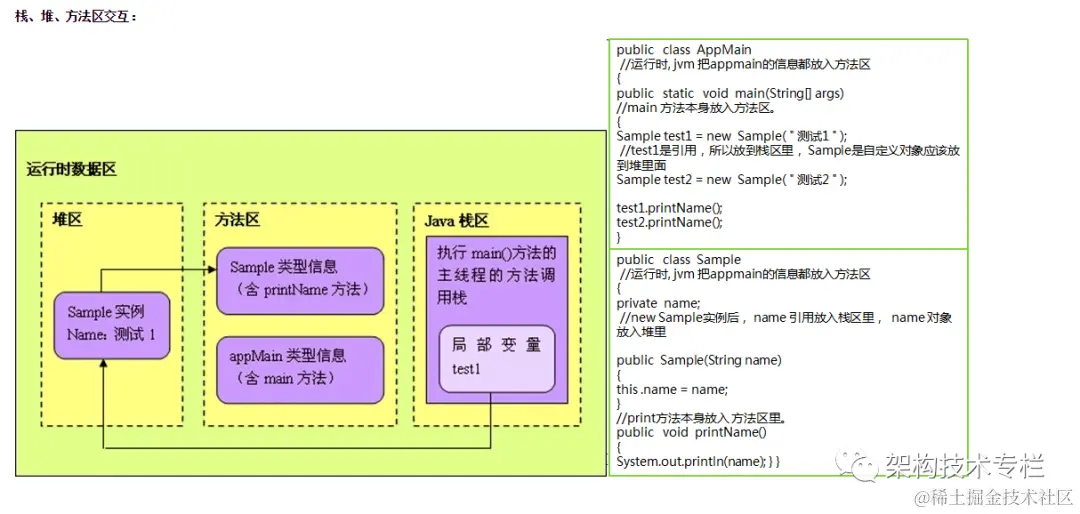

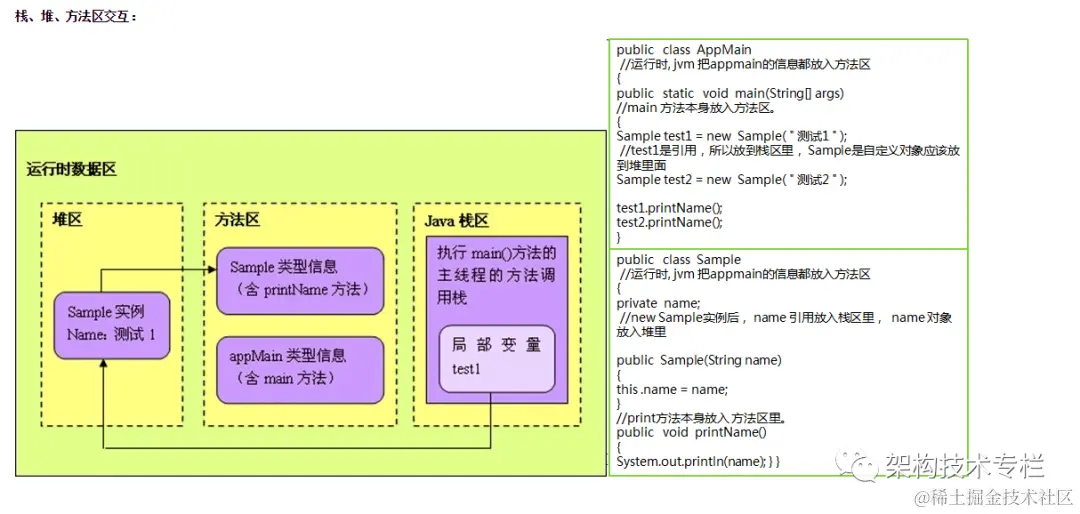

栈、堆、方法区的交互关系

永久代和元空间内存使用上的差异?

Java虚拟机规范中只定义了方法区用于存储已被虚拟机加载的类信息、常量、静态变量和即时编译后的代码等数据

- jdk1.7开始符号引用存储在native heap中,字符串常量和静态类型变量存储在普通的堆区中,但分离的并不彻底,此时永久代中还保存另一些与类的元数据无关的杂项

- jdk8后HotSpot 原永久代中存储的类的

元数据将存储在metaspace

中,而

类的静态变量和字符串常量将放在Java堆中

,metaspace是方法区的一种实现,只不过它使用的不是虚拟机内的内存,而是本地内存。在元空间中保存的数据比永久代中纯粹很多,就只是类的元数据,这些信息只对编译期或JVM的运行时有用。

- 永久代有一个JVM本身设置固定大小上线,无法进行调整,而

元空间使用的是直接内存,受本机可用内存的限制,并且永远不会得到java.lang.OutOfMemoryError

。

- 符号引用没有存在元空间中,而是存在native heap中

,这是两个方式和位置,不过都可以算作是本地内存,在虚拟机之外进行划分,没有设置限制参数时只受物理内存大小限制,即只有占满了操作系统可用内存后才OOM。

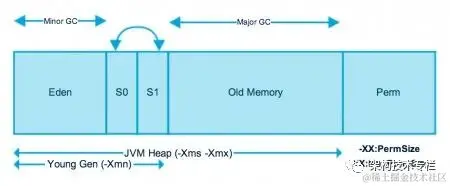

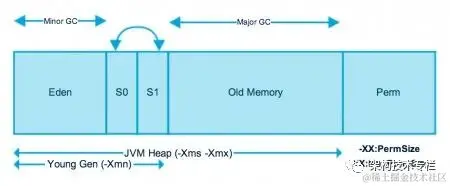

堆区内存是怎么细分的?

对于大多数应用,Java 堆是 Java 虚拟机管理的内存中最大的一块,被所有线程共享。此内存区域的唯一目的就是存放对象实例,几乎所有的对象实例以及数据都在这里分配内存。

为了进行高效的垃圾回收,虚拟机把堆内存

逻辑上

划分成三块区域(分代的唯一理由就是优化 GC 性能):

- 新生带(年轻代):新对象和没达到一定年龄的对象都在新生代

- 老年代(养老区):被长时间使用的对象,老年代的内存空间应该要比年轻代更大

Java 虚拟机规范规定,Java 堆可以是处于物理上不连续的内存空间中,只要逻辑上是连续的即可,像磁盘空间一样。实现时,既可以是固定大小,也可以是可扩展的,主流虚拟机都是可扩展的(通过

-Xmx

和

-Xms

控制),如果堆中没有完成实例分配,并且堆无法再扩展时,就会抛出

OutOfMemoryError

异常。

年轻代是所有新对象创建的地方。当填充年轻代时,执行垃圾收集。这种垃圾收集称为

Minor GC

。年轻一代被分为三个部分——伊甸园(

Eden Memory

)和两个幸存区(

Survivor Memory

,被称为from/to或s0/s1),默认比例是

8:1:1

- 大多数新创建的对象都位于 Eden 内存空间中

- 当 Eden 空间被对象填充时,执行

Minor GC

,并将所有幸存者对象移动到一个幸存者空间中

- Minor GC 检查幸存者对象,并将它们移动到另一个幸存者空间。所以每次,一个幸存者空间总是空的

- 经过多次 GC 循环后存活下来的对象被移动到老年代。通常,这是通过设置年轻一代对象的年龄阈值来实现的,然后他们才有资格提升到老一代

旧的一代内存包含那些经过许多轮小型 GC 后仍然存活的对象。通常,垃圾收集是在老年代内存满时执行的。老年代垃圾收集称为 主GC(Major GC),通常需要更长的时间。

大对象直接进入老年代(大对象是指需要大量连续内存空间的对象)。这样做的目的是避免在 Eden 区和两个Survivor 区之间发生大量的内存拷贝

JVM中对象在堆中的生命周期?

- 在 JVM 内存模型的堆中,堆被划分为新生代和老年代

- 新生代又被进一步划分为

Eden区

和

Survivor区

,Survivor 区由

From Survivor

和

To Survivor

组成

- 当创建一个对象时,对象会被优先分配到新生代的 Eden 区

- 此时 JVM 会给对象定义一个

对象年轻计数器

(

-XX:MaxTenuringThreshold

)

- 当 Eden 空间不足时,JVM 将执行新生代的垃圾回收(Minor GC)

- JVM 会把存活的对象转移到 Survivor 中,并且对象年龄 +1

- 对象在 Survivor 中同样也会经历 Minor GC,每经历一次 Minor GC,对象年龄都会+1

- 如果分配的对象超过了

-XX:PetenureSizeThreshold

,对象会

直接被分配到老年代

JVM中对象的分配过程?

为对象分配内存是一件非常严谨和复杂的任务,JVM 的设计者们不仅需要考虑内存如何分配、在哪里分配等问题,并且由于内存分配算法和内存回收算法密切相关,所以还需要考虑 GC 执行完内存回收后是否会在内存空间中产生内存碎片。

- new 的对象先放在伊甸园区,此区有大小限制

- 当伊甸园的空间填满时,程序又需要创建对象,JVM 的垃圾回收器将对伊甸园区进行垃圾回收(Minor GC),将伊甸园区中的不再被其他对象所引用的对象进行销毁。再加载新的对象放到伊甸园区

- 然后将伊甸园中的剩余对象移动到幸存者 0 区

- 如果再次触发垃圾回收,此时上次幸存下来的放到幸存者 0 区,如果没有回收,就会放到幸存者 1 区

- 如果再次经历垃圾回收,此时会重新放回幸存者 0 区,接着再去幸存者 1 区

- 什么时候才会去养老区呢?默认是 15 次回收标记

- 在养老区,相对悠闲。当养老区内存不足时,再次触发 Major GC,进行养老区的内存清理

- 若养老区执行了 Major GC 之后发现依然无法进行对象的保存,就会产生 OOM 异常

什么是 TLAB (Thread Local Allocation Buffer)?

- 从内存模型而不是垃圾回收的角度,对 Eden 区域继续进行划分,JVM 为每个线程分配了一个私有缓存区域,它包含在 Eden 空间内

- 多线程同时分配内存时,使用 TLAB 可以避免一系列的非线程安全问题,同时还能提升内存分配的吞吐量,因此我们可以将这种内存分配方式称为

快速分配策略

- OpenJDK 衍生出来的 JVM 大都提供了 TLAB 设计

为什么要有 TLAB ?

- 堆区是线程共享的,任何线程都可以访问到堆区中的共享数据

- 由于对象实例的创建在 JVM 中非常频繁,因此在并发环境下从堆区中划分内存空间是线程不安全的

- 为避免多个线程操作同一地址,需要使用加锁等机制,进而影响分配速度

尽管不是所有的对象实例都能够在 TLAB 中成功分配内存,但 JVM 确实是将 TLAB 作为内存分配的首选。

在程序中,可以通过

-XX:UseTLAB

设置是否开启 TLAB 空间。

默认情况下,TLAB 空间的内存非常小,仅占有整个 Eden 空间的 1%,我们可以通过

-XX:TLABWasteTargetPercent

设置 TLAB 空间所占用 Eden 空间的百分比大小。

一旦对象在 TLAB 空间分配内存失败时,JVM 就会尝试着通过使用加锁机制确保数据操作的原子性,从而直接在 Eden 空间中分配内存。