Windbg的命令

前面介绍了Windbg的UI功能,也基本上能完成基本的调试任务,但是WinDBG主要是以命令方式工作的,这些命令在Command Window里输入。WinDBG共支持三类命令:标准命令、元命令和扩展命令。某些命令仅在实时调试中可用,其他命令仅在调试转储文件时可用。某些命令仅在用户模式调试期间可用,其他命令仅在内核模式调试期间可用。只有当目标在某些处理器上运行时,某些命令才可用。

一、标准命令

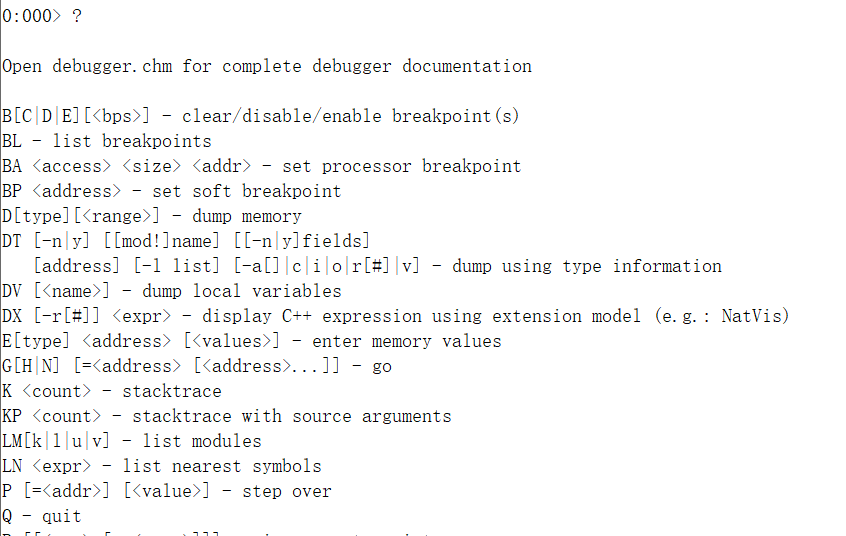

标准命令(standard command)用来提供适用于所有调试目标的基本调试功能.标准命令通常是一两个字符(version除外)或者符号,只有version等少数命令除外。标准命令的第一个字符是不分大小写的, 第二个字符可能区分大小写。所有标准命令都是实现在WinDBG内部的, 执行这些命令时不需要加载任何扩展模块。迄今为止, WinDBG调试器共实现了130多条标准命令, 分为60多个系列. 为了便于记忆, 可以根据功能将标准命令归纳为如下18个子类。在命令编辑框中输入一个问号(?), 可以显示出主要的标准命令和每个命令的简单介绍。

- 控制调试目标执行

| 功能 | 命令 | 描述/助记 | 补充信息 |

| 恢复运行 | g | Go | ~123g, ~#g, ~*g |

| 跟踪执行 | t | Trace | |

| 单步执行 | p | Step | |

| 追踪监视 | wt | Trace and Watch Data |

windbg命令行选项

使用调试器标记语言

使用 DML 自定义调试器输出

调试器标记语言 (DML) 提供了一种机制增强来自调试器和扩展的输出。 与 HTML 类似,调试器的标记支持允许将输出包括显示指令和额外非显示的标记窗体中的信息。 调试器用户界面,WinDbg 等中分析出提供在 DML 来增强所显示的信息,并提供新行为,如网格显示和排序的额外信息。 本主题介绍如何自定义使用 DML 您调试输出。

DML 是可用在 Windows 10 及更高版本。

DML 概述

上的 DML 的主要权益以提供链接到调试器输出中的相关信息的能力。 一个主要的 DML 标记的是<链接>标记用于指示是否可以通过链接访问与一种输出相关的信息输出生成者的说明操作。 为使用 web 浏览器中的 HTML 链接这样用户能够导航超链接的信息。

提供超链接内容的优点是,它可用于增强的调试程序和调试器扩展功能可发现性。 调试器和及其扩展插件包含大量的功能,但它可能很难确定要在不同的方案中使用的相应命令。 用户必须只需知道哪些命令可以用来在特定方案中使用。 用户和内核调试之间的差异会进一步增加复杂性。 这通常意味着许多用户不了解可帮助他们的调试命令。 DML 链接提供了任意调试命令来包装在备用的演示文稿,例如说明性文本,可单击的菜单系统或链接的帮助功能。 使用 DML,可以对命令输出来增强用户引导到适用于手头的任务的其他相关命令。

调试器 DML 支持

- 命令窗口在 WinDbg 中的支持所有 DML 行为,将显示颜色、 字体样式和链接。

- 使用颜色模式已启用,则返回 true 的控制台中运行时,控制台调试器 – ntsd、 cdb 和 kd – 仅支持 DML,和唯一的颜色属性。

- 通过重定向 I/O 的调试器,ntsd – d 或 remote.exe 会话不会显示任何颜色。

DML 内容规范

DML 不应为完整表示语言,如 HTML。 DML 是精心设计的非常简单,只有少量的标记。

由于并非所有调试器工具都支持多格式文本,DML 旨在允许 DML 和纯文本之间的简单转换。 这样,DML 所有现有的调试器工具中的函数。 可以轻松地支持颜色等效果,因为删除它们不会删除携带的实际信息的文本。

DML 不是 XML。 DML 不会尝试执行语义,也不是结构化信息。 如上所述,必须有一个简单之间的映射 DML 和纯文本,因此,DML 标记是所有可放弃。

DML 不是可扩展的;所有标记是预定义的并验证,以跨所有现有的调试器工具工作。

标记结构

类似于 XML,DML 标记可以作为起点<tagname [args] >并且下列</tagname>。

特殊字符

DML 内容大致遵循特殊字符的 XML/HTML 的规则。 字符 &、 <,>和"很特殊,不能使用以纯文本。 等效的转义字符的版本为 &、 <,>和"。 例如此文本:

"Alice 和 Bob 想 3 < 4"

将转换为以下 dml。

Windbg命令的语法规则系列(一)

本文介绍使用调试器命令必须遵循的语法规则。使用Windbg调试时,应遵守以下一般语法规则:

- 您可以在命令和参数中使用大小写字母的任意组合,除非在本节的主题中特别指出。

- 可以用一个或多个空格或逗号(,)分隔多个命令参数。

- 通常可以省略命令与其第一个参数之间的空格。如果这种省略不会造成任何歧义,则可以经常省略其他空格。

阅读本文中的命令引用注意以下事项:

- 粗体字体的字符表示必须逐字键入的项目。

- 斜体字体的字符表示参考主题“参数”部分中解释的参数。

- 括号([xxx])中的参数是可选的。带有竖线([XXX|YYY])的括号表示可以使用一个或无一个封闭参数。

带竖线(XXX|YYY)的大括号表示必须仅使用其中一个封闭参数。