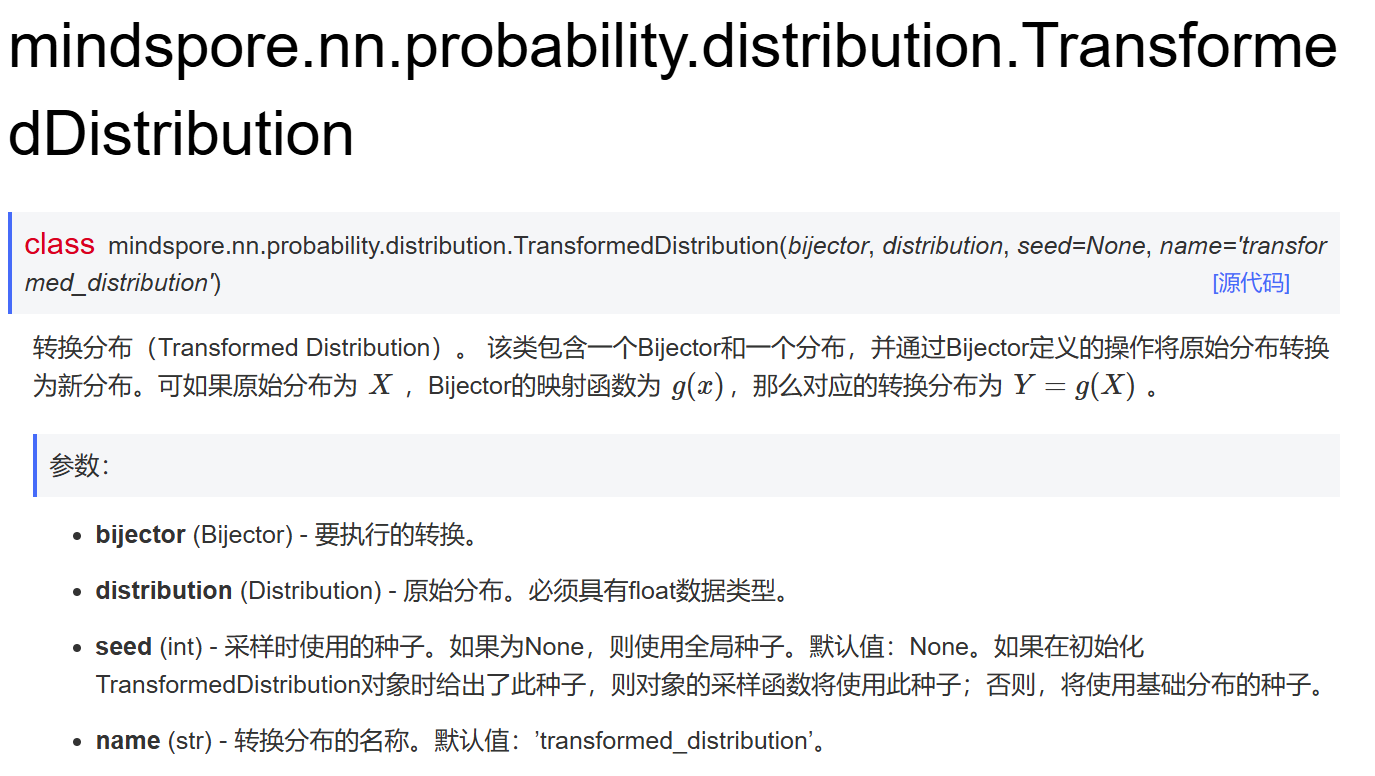

解锁 Git Log 更多实用技巧

目前,在软件开发的协作中,

Git

无疑是版本控制的王者。

而其中的

git log

命令,犹如一把强大的历史探寻之剑,能够帮助我们深入洞察项目的演进历程。

本篇将为大家整理解读几个实用的

git Log

技巧,让你的项目管理和代码审查工作如虎添翼。

1. 挖掘代码深处的历史变更

git log

具备

按文件内容搜索提交

的强大功能。

使用

git log -S "字符串"

命令,我们可以搜索提交历史中添加了特定字符串的提交(默认区分大小写)。

比如,我想看看我的代码中何时添加了

class FadeVideo

,可以使用如下命令:

$ git log -S 'class FadeVideo'

commit 045447e05a735850fe7eb8274d95f7499042fe98 (HEAD -> master, origin/master, origin/HEAD)

Author: wangyubin <linuxr@aliyun.com>

Date: Fri Dec 20 16:50:30 2024 +0800

add animations video fade

如果想要不区分大小写进行搜索,可以添加

-i

选项。

$ git log -i -S 'class fadevideo'

commit 045447e05a735850fe7eb8274d95f7499042fe98 (HEAD -> master, origin/master, origin/HEAD)

Author: wangyubin <linuxr@aliyun.com>

Date: Fri Dec 20 16:50:30 2024 +0800

add animations video fade

$ git log -S 'class fadevideo' # 没有-i选项,搜索不到结果

结合 -p 选项,还能同时查看这些提交的差异变化。

$ git log -i -S 'class fadevideo' -p

commit 045447e05a735850fe7eb8274d95f7499042fe98 (HEAD -> master, origin/master, origin/HEAD)

Author: wangyubin <linuxr@aliyun.com>

Date: Fri Dec 20 16:50:30 2024 +0800

add animations video fade

diff --git a/short_videos/animations/fade.py b/short_videos/animations/fade.py

new file mode 100644

index 0000000..e924471

--- /dev/null

+++ b/short_videos/animations/fade.py

@@ -0,0 +1,268 @@

+titles = [

+ "基本使用",

+ "FadeIn的shift参数",

+ "FadeIn的target_position参数",

+ "FadeOut的scale参数",

+]

+codes = [

+ """# 创建一个圆形

这在我们想要追溯某个特定代码片段或函数是在何时被引入项目,以及在后续提交中如何被修改时,发挥着不可替代的作用,能够帮助我们深入理解代码的演变逻辑。

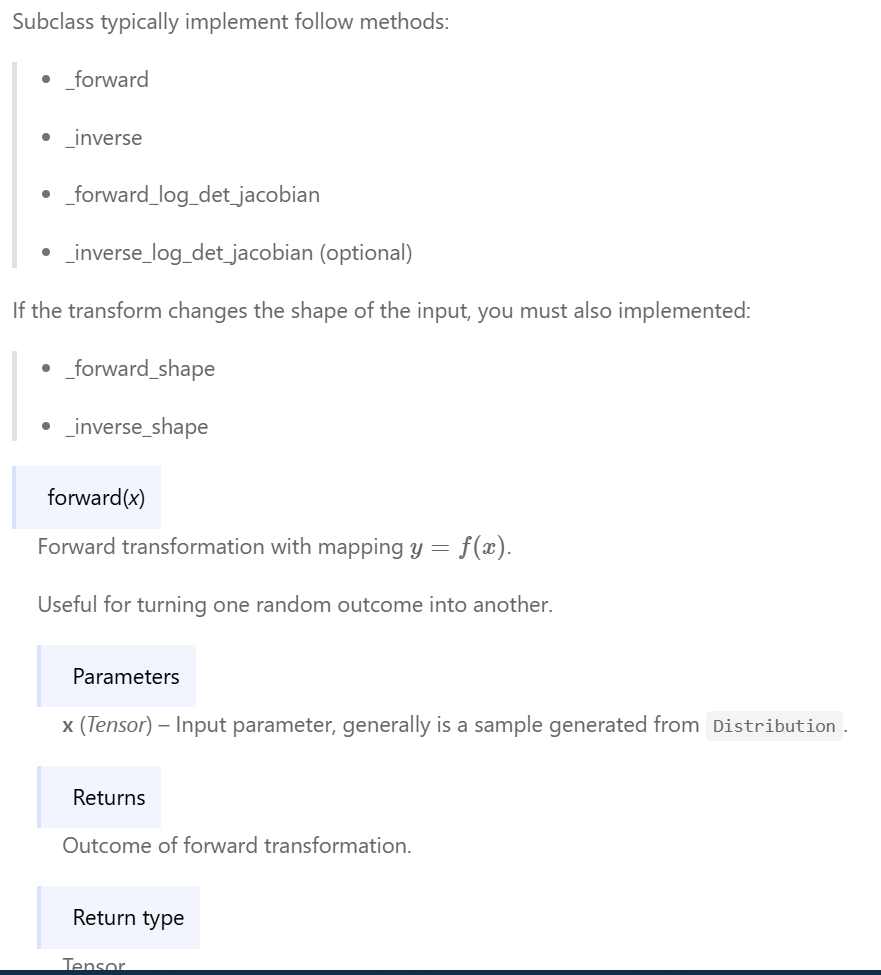

2. 深入代码差异的提交详情

仅仅知道提交的存在是不够的,很多时候我们需要了解每次提交到底对代码做了哪些具体的更改。

git log -p

命令在显示提交日志的同时,还会展示每次提交所带来的差异变化。

$ git log -p

commit 045447e05a735850fe7eb8274d95f7499042fe98 (HEAD -> master, origin/master, origin/HEAD)

Author: wangyubin <linuxr@aliyun.com>

Date: Fri Dec 20 16:50:30 2024 +0800

add animations video fade

diff --git a/main.py b/main.py

index e15c8a1..e340db1 100644

--- a/main.py

+++ b/main.py

@@ -59,6 +59,7 @@ def animations_help():

params = {

"text": "文字的创建与销毁",

"graph": "图形的创建与销毁",

+ "fade": "淡入淡出",

}

这对于代码审查、问题排查以及理解项目功能的逐步演进至关重要。

比如,当发现某个功能出现异常时,通过

git log -p

查看相关提交的差异,能够快速定位到是哪个提交引入了问题,以及具体的代码改动之处,从而高效地进行修复。

3. 对比分支开发进度

在多人协作开发或者多分支并行开发的场景下,经常需要比较不同分支之间的差异。

git log master..develop

命令就可以显示

develop

分支中存在但

master

分支中不存在的提交。

这在准备将某个分支的功能合并到主分支之前,或者想要了解不同分支的开发进度差异时非常有用。

比如,下面我的一个项目,比较其中两个分支的区别:

$ git branch

* collector

develop

master

$ git log develop..collector

commit ee035a3ed6aa71d8650d4dc823be6a6045894e11 (HEAD -> collector, origin/collector)

Author: wangyubin <linuxr@aliyun.com>

Date: Sun Dec 1 10:11:11 2024 +0800

use poltly to display kline

commit d8b65fad3beca572fa1e7d57fa90e5c9345e575f

Author: wangyubin <linuxr@aliyun.com>

Date: Sat Nov 30 00:55:49 2024 +0800

update kline utils

4. 简洁至上的提交概览

在查看项目提交历史时,有时候我们不需要冗长的详细信息,只希望快速了解每个提交的大致情况。

git log --oneline

就完美地满足了这一需求。它将每个提交压缩成一行,仅仅展示简短的提交哈希和提交消息。

这样一来,我们能够在有限的屏幕空间内迅速扫视众多提交,把握项目的主要更新脉络。

$ git log --oneline

ee035a3 (HEAD -> collector, origin/collector) use poltly to display kline

d8b65fa update kline utils

f3d749a update K线显示

540e2ef add k线查看

efaf17e update readme

30e672d add coin info utils

35cdd3e fix 数据采集改造后的错误

03f1626 fix 配置文件加载错误

a7e5c42 rework collector

5d69716 fix binance collector start time

8503533 rework binance collector

59cc2b6 add uv project manager

1f29fbf update binance api

924545c update 整体结构

... ...

5. 追踪特定文件的变更轨迹

当我们重点关注某个或某些文件的历史变化时,通过

git log <filename>

的形式,我们可以过滤出对指定文件进行更改的提交。

如果需要同时查看多个文件的提交历史,只需像

git log file1 file2 file3

这样传递多个文件名即可。

$ git log .\config.py

commit 30e672d3e78c9fbc6198373940a464b8132a9b06

Author: wangyubin <linuxr@aliyun.com>

Date: Thu Nov 7 18:01:54 2024 +0800

add coin info utils

commit a7e5c4271cad314460a1793c8c62aa93acd70077

Author: wangyubin <linuxr@aliyun.com>

Date: Tue Oct 29 11:57:20 2024 +0800

rework collector

commit 5d697169b687ea02ad4723e74fbc3052e033a6c4

Author: wangyubin <linuxr@aliyun.com>

Date: Tue Oct 29 11:33:37 2024 +0800

fix binance collector start time

6. 基于关键字的提交搜索

有时候,我们只记得提交消息中的某个关键字或短语,想要快速找到相关的提交。

使用

git log --grep="模式"

可以按照指定模式(默认区分大小写)过滤提交,

如果不希望区分大小写,可以使用

git log -i --grep="模式"

。

这在项目规模较大,提交数量众多的情况下,能够帮助我们迅速定位到与特定任务、功能或问题相关的提交记录,极大地提高了代码查找和问题追溯的速度。

$ git log --grep "数据采集"

commit 35cdd3e75933c1a99431ea86d0625faff49f1c16

Author: wangyubin <linuxr@aliyun.com>

Date: Thu Oct 31 14:41:46 2024 +0800

fix 数据采集改造后的错误

commit 7edf14cf0cc4478d422dd752d32de146bedefa6f

Author: wangyubin <linuxr@aliyun.com>

Date: Mon May 27 10:12:08 2024 +0800

update 数据采集

7. 聚焦特定开发者的工作成果

在团队协作开发中,了解每个成员的贡献情况是非常有意义的。

git log --author="作者名"

命令允许我们按照作者来过滤提交。

git 在此处是按照正则表达式模式进行过滤的,这意味着不需要精确的名称匹配,也不区分大小写。

$ git log --author="linuxr"

commit ee035a3ed6aa71d8650d4dc823be6a6045894e11 (HEAD -> collector, origin/collector)

Author: wangyubin <linuxr@aliyun.com>

Date: Sun Dec 1 10:11:11 2024 +0800

use poltly to display kline

commit d8b65fad3beca572fa1e7d57fa90e5c9345e575f

Author: wangyubin <linuxr@aliyun.com>

Date: Sat Nov 30 00:55:49 2024 +0800

update kline utils

commit f3d749a335c91385cd6443572a0e5082d05734d1

Author: wangyubin <linuxr@aliyun.com>

Date: Fri Nov 29 18:51:41 2024 +0800

update K线显示

... ...

8. 突出项目的合并节点

在复杂的项目开发中,分支合并是常见的操作。

git log --merges

命令能够让我们专注于查看当前分支中的合并提交。

这些合并提交往往代表着不同分支开发成果的整合,对于理解项目的整体架构整合和功能合并过程具有重要意义。

$ git log --merges

commit 97078ccd1545a4d5dc73eac4f92487607ee93010 (origin/master, master)

Merge: 49a457c e49da8b

Author: wangyubin <linuxr@aliyun.com>

Date: Sun Oct 13 20:50:34 2024 +0800

Merge branch 'master' of gitee.com:wangyubin/b_st_middle

commit b29438b16351552a54c8e4fbe477154059d2dcd5

Merge: 9e4a212 366875c

Author: wangyubin <linuxr@aliyun.com>

Date: Mon May 27 10:52:28 2024 +0800

Merge branch 'master' of gitee.com:wangyubin/b_st_middle

9. 精准定位特定时段的变更

在项目开发过程中,我们常常需要关注特定时间段内的代码改动,

git log

提供了强大的时间过滤功能。

比如,当我们想要查看 2024 年 6 月 1 日之后的提交时,可以使用

git log --after="2024-06-01"

命令。

若要进一步缩小范围,查看 2024 年 6 月 1 日至 6 月 25 日之间的提交,只需执行

git log --after="2024-06-01" --before="2024-06-25"

。

而且,它还支持诸如 "

yesterday

"、"

today

"、"

10 day ago

" 等便捷的日期格式,这使得我们能够根据实际需求灵活地筛选出所需时间段的提交记录。

$ git log --after="2024-06-01" --before="2024-06-25" --oneline

ff5b0b1 add example single string math tex

f3aba71 优化一些场景的切换

f1ca6c7 add integer video

c3a407f 生成视频的结构

db02c64 add main for videos

3358093 add bulleted list example

dd48bd1 add title example

bb3e513 add infra and end page

e36946a add integer example

$ git log --after "10 days ago" --oneline

045447e (HEAD -> master, origin/master, origin/HEAD) add animations video fade

22a0d9f add animations rotate example

f05b8d1 add animation graph video

2664733 add animations graph video

93cf0cf add animation indication example

d9bab37 add animations video text

9462253 add animation grow example

784d4f9 add video Polyhedron

c372485 add animation fade example

10. 个性化的提交展示

最后一个技巧是关于自定义

git log

的日志消息格式。

使用

git log --pretty=format:"格式字符串"

,我们可以根据自己的需求灵活定制日志的显示格式。

比如,

git log --pretty=format:"%Cred%an - %ar%n %Cblue %h -%Cgreen %s %n"

,

通过这种方式,我们可以选择显示提交作者、提交时间、提交哈希以及提交消息等不同的信息,并对其进行颜色标记等格式化处理,使日志信息更加清晰易读,满足不同场景下对提交信息展示的个性化要求。

11. 总结

git log的参数其实有很多,参考:

https://git-scm.com/docs/git-log

本篇只是总结了一些平时使用的几个技巧,如果大家有其他更好的查看日志的技巧,欢迎交流。